Vogliamo fare una piccola riflessione sulle dimostrazioni live che abbiamo visto e vedremo ai vari eventi come quello appena svolto del Google I/O 2018, per trarre alcune considerazioni magari anche assieme a voi!

Quando vediamo una “live demo” presentata da grandi vertici aziendali tutto funziona perfettamente come dovrebbe, senza il minimo intoppo (eccetto casi particolari). Non a tutti viene naturale pensare a cosa si cela dietro a pochi secondi di dimostrazione. Il più delle volte per realizzare un video di 30 secondi sono necessarie ore o giorni di lavoro, per prepararsi ad una dimostrazione di una funzionalità sono necessari giorni o settimane di preparazione, e stiamo solo parlando dell’atto di presentare in se. Se considerate poi che ogni funzionalità deve essere stata pensata, progettata, sviluppata e testata per raggiungere una forma basilare in cui tutto sembra funzionare, in questo caso si può arrivare a mesi o anni di sviluppo.

Tutto questo per dirvi quanto sia complicato arrivare anche minimamente preparati ad una presentazione del calibro di Google I/O 2018.

Come abbiamo detto, molto viene realizzato al fine di raggiungere una forma “stabile” che potrà essere presentata al pubblico senza troppo timore di incorrere in fail… ma in seguito tutto procederà secondo la tabella di marcia? E se la tabella di marcia arrivasse soltanto alla presentazione di un prodotto in modo da appagare la sete di conoscenza degli spettatori? Insomma certe cose, molto rare, potrebbero venire accantonate per vari motivi: l’interesse svanisce, la tecnologia non è sufficiente, lo sviluppo non ne giustifica il progresso, ecc.

Da programmatore software conosco bene le dinamiche che vengono a crearsi durante la creazione di una funzionalità e fidatevi, se il risultato finale è di dieci funzioni, inizialmente erano state concepite come cento, ma a causa di diversi fattori molte sono state abbandonate durante il ciclo di sviluppo.

Un esempio di tale problematica potrebbe essere capitata anche con Google Duplex, un immenso salto in avanti in quello che ci aspettiamo da un’AI orientata al mondo consumer, talmente grande che la gente potrebbe far fatica a credere che sia reale.

A detta di Sundar Pichai, CEO di Google, Duplex inizierà a essere presente in forma sperimentale a partire da quest’estate, ma cosa dovremmo aspettarci? Come detto precedentemente, a volte le cose più impressionanti mostrate sul palco non riescono a diventare un prodotto finale che le persone possono effettivamente usare, il tutto per vari motivi e Pichai dovrebbe esserne ben consapevole.

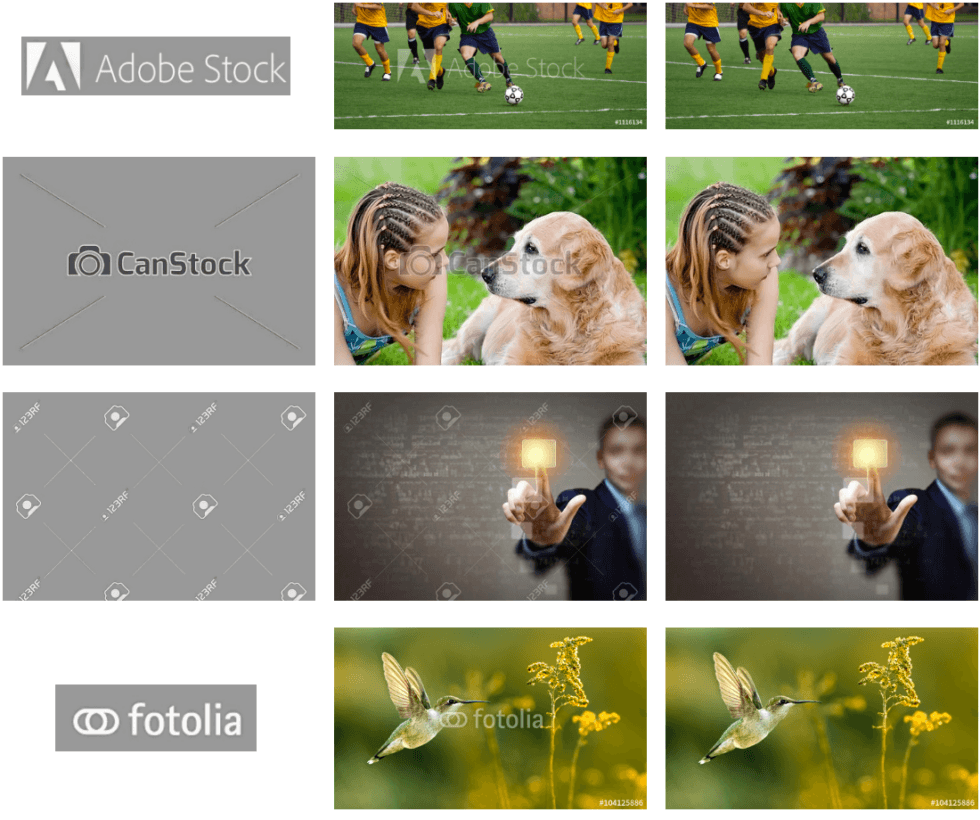

Durante il precedente Google I/O 2017 è stata dimostrata una nuova funzionalità della fotocamera che, con un solo tocco, avrebbe permesso agli utenti di rimuovere gli oggetti indesiderati dalle loro foto utilizzando i potenti sistemi di Machine Learning implementati nel software. Ricordi resi perfetti, chi non lo vorrebbe? Quante volte ci sarà capitato di scattare un foto in una condizione quasi impossibile da replicare, ma con un difetto che quasi la rovina totalmente. Una funzionalità del genere ci permetterebbe di rimuovere un oggetto, una persona, o effettuare una qualsiasi modifica senza creare difetti alla nostra immagine e senza avere conoscenze approfondite di Photoshop, Pixelmator o Snapseed, sarebbe sufficiente l’uso di una classica app di galleria fotografica.

“Se scatti una foto a tua figlia in una partita di baseball e c’è qualcosa che la ostacola, possiamo fare noi il lavoro duro, rimuovere l’ostruzione e avere davanti a te l’immagine di ciò che ti sta a cuore”.

Sundar Pichai

Ma nonostante la promessa del CEO di Google che questa incredibile funzione sarebbe stata disponibile “molto presto”, non se ne vede ancora l’ombra. Alcuni codici apparsi in Google Foto hanno suggerito che la rimozione degli oggetti sia ancora in fase di sviluppo, ma Google non ne ha fatto menzione nemmeno durante l’evento di ieri a distanza di un intero anno.

Un altro esempio potrebbe essere la ricerca condotta e pubblicata da alcuni ricercatori Google nell’estate dell’anno scorso, secondo cui grazie all’implementazione di software di Machine Learning sarebbe possibile individuare un watermark applicato a delle immagini e rimuoverlo totalmente sempre senza compromettere l’immagine stessa.

Un software come questo, che sfrutta la tecnologia di Computer Vision per rimuovere marchi o simboli dalle immagini per renderle totalmente “pulite” e riutilizzabili senza incorrere ad alcun problema, sarebbe il sogno di molte persone. Peccato che dopo la pubblicazione del documento ufficiale e di una dimostrazione non si sia più sentito parlare di questa ricerca.

Sono proprio questi alcuni esempi in cui i “poteri” del Machine Learning possono tornare utili, ma per vari motivi non sono bastati. Forse l’AI non è ancora sufficientemente capace di compiere azioni come quelle dimostrate inizialmente, o forse i risultati ottenuti in corso d’opera non sono stati all’altezza delle aspettative.

La speranza però è l’ultima a morire, magari a Google serve solo molto tempo prima di rilasciare un prodotto al pubblico perché vuole assicurarsi che tutto funzioni al meglio sin da subito.

Se ben ricordate, Pichai al Google I/O 2017 ha dimostrato una funzione di Google Lens che consentiva di puntare la fotocamera verso un testo nel mondo reale per poi poterlo copiare e incollare in un’applicazione sul telefono. Ieri al Google I/O 2018 la stessa funzione è stata ripresentata, segno che c’è sempre speranza quando si parla di Google.