Continua il ricchissimo periodo di annunci targati Google e legati al mondo dell’intelligenza artificiale che, per quanto concerne il colosso di Mountain View, riguardano soprattutto Gemini.

Dopo gli annunci relativi a Gemma 3, a Gemini Robotics e alla più ampia disponibilità dell’output delle immagini native di ieri, oggi Big G si sbizzarrisce annunciando l’arrivo di tante nuove funzionalità nell’app: ci sono novità per il modello 2.0 Flash Thinking Experimental e per Deep Research, un nuovo modello più personalizzato e contestuale, miglioramenti alle app connesse; inoltre, le Gem sono ora disponibili per tutti. C’è spazio anche per una novità che investe Gemini in Android Studio. Andiamo a scoprire tutti i dettagli.

Indice:

Motorola edge 60, 8/256 GB

50+50+10MP, 6.67'' pOLED 120Hz, Batteria 5200mAh, ricarica 68W, Android 15

Google annuncia tante novità per l’app di Gemini

Tramite un post pubblicato sul blog The Keyword, Google ha annunciato tantissime novità che investono Gemini nella sua declinazione da “app”, ovvero l’assistente con cui possiamo avere a che fare quotidianamente tramite i nostri smartphone, tablet e computer.

Oggi stiamo apportando importanti miglioramenti alle prestazioni e alla disponibilità delle nostre funzionalità Gemini più popolari e aggiungendo una nuova funzionalità che renderà Gemini ancora più personale e utile.

Novità per il modello 2.0 Flash Thinking Experimental

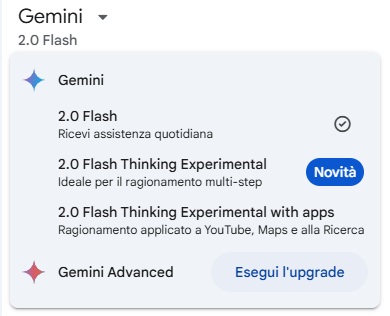

Google ha iniziato a rilasciare una versione aggiornata del modello 2.0 Flash Thinking Experimental che, alla pari del modello “stabile” 2.0 Flash, ora supporta il caricamento dei file e altre funzionalità aggiuntive.

Per gli abbonati Advanced c’è una novità in più: il colosso di Mountain View ha infatti esteso la finestra di contesto a un milione di token, permettendo agli utenti di risolvere problemi più complessi anche analizzando una grande quantità di informazioni.

Novità per Deep Research che diventa gratuito

La scorsa settimana è trapelata l’indiscrezione secondo cui la funzionalità Deep Research, lanciata da Google lo scorso dicembre e implementata nell’app per Android (ma solo per gli abbonati Advanced) a fine gennaio (con il modello 1.5 Pro with Deep Research), sarebbe stata estesa anche agli utenti standard.

Questa indiscrezione si concretizza oggi, con l’annuncio da parte di Google relativo al fatto che la funzionalità è disponibile per tutti gli utenti, inclusi gli utenti standard, tramite il modello 2.0 Flash Thinking Experimental (che ne migliora le performance).

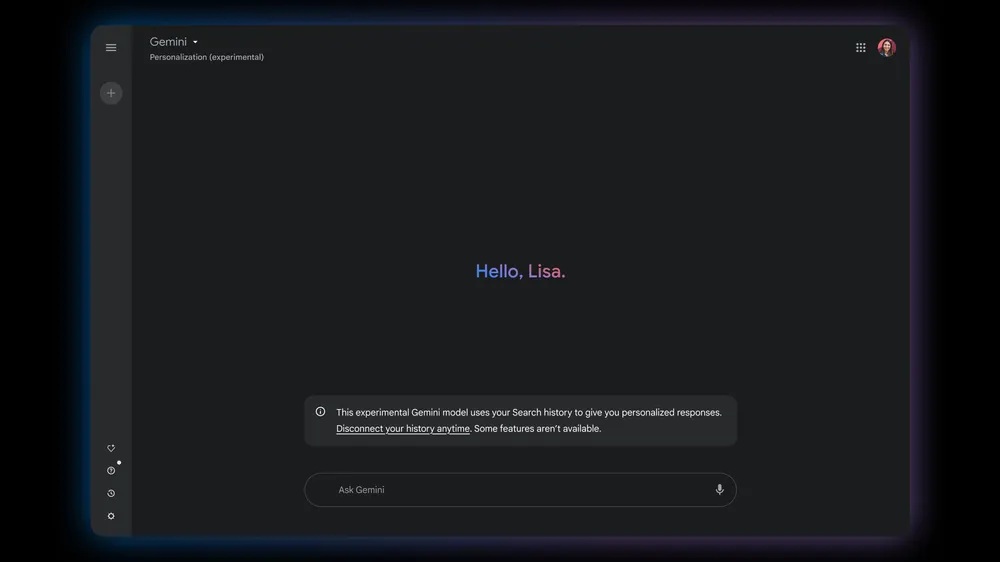

Nuovo modello Personalization (experimental)

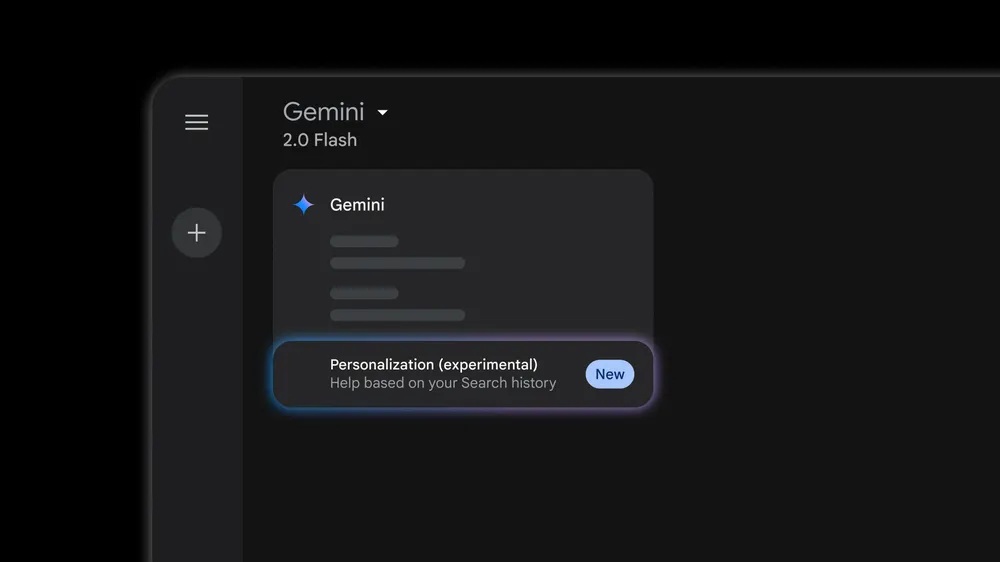

La scorsa settimana erano emerse le prime evidenze anche su un nuovo modello, nascosto all’interno dell’ultima beta dell’app di Gemini per Android ma non effettivamente disponibile per gli utenti.

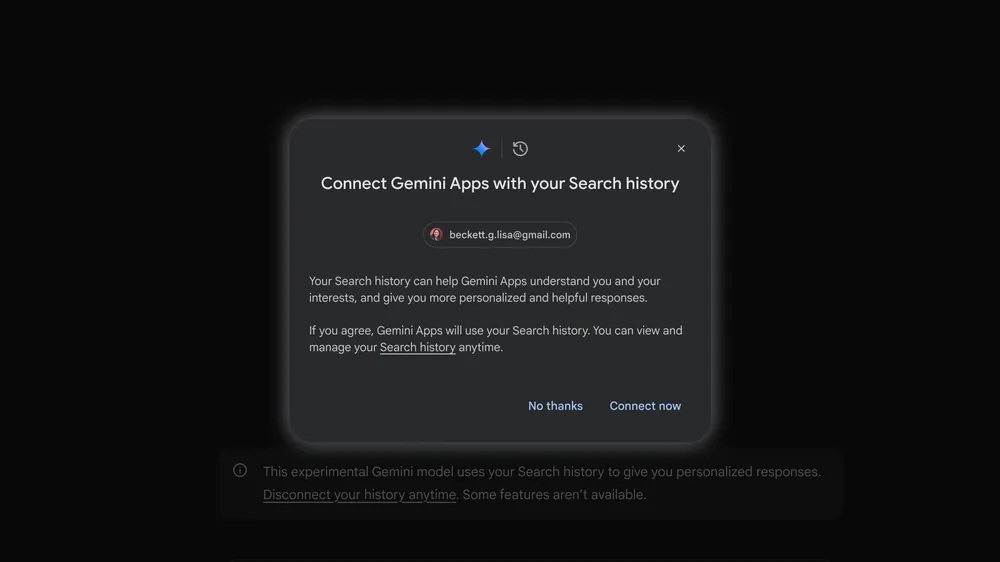

Oggi Google è passata ai fatti, annunciando il nuovo modello Personalization Experimental per il proprio assistente, che punta così a diventare sempre più personalizzato (oltre che utile) e a comprendere sempre meglio le esigenze dell’utente.

Questo nuovo modello, disponibile nel selettore del modello all’interno dell’app di Gemini, permette all’assistente di fornire risposte basate anche sulla cronologia di ricerche dell’utente (ammesso che l’utente fornisca il suo consenso) ma solo quando accedere alla cronologia delle ricerche verrà ritenuto necessario.

Nei prossimi mesi, questo modello potrà connettersi ad altre app e servizi Google (come foto e YouTube): a quel punto, Gemini potrà fornire approfondimenti ancor più personalizzati, attingendo dalle attività dell’utente (foto caricate, cronologia delle visualizzazioni su YouTube).

Per maggiori dettagli sul nuovo modello Personalization (experimental) vi rimandiamo al post dedicato che Google ha pubblicato sul blog The Keyword.

Le app connesse in Gemini diventano ancora più “potenti”

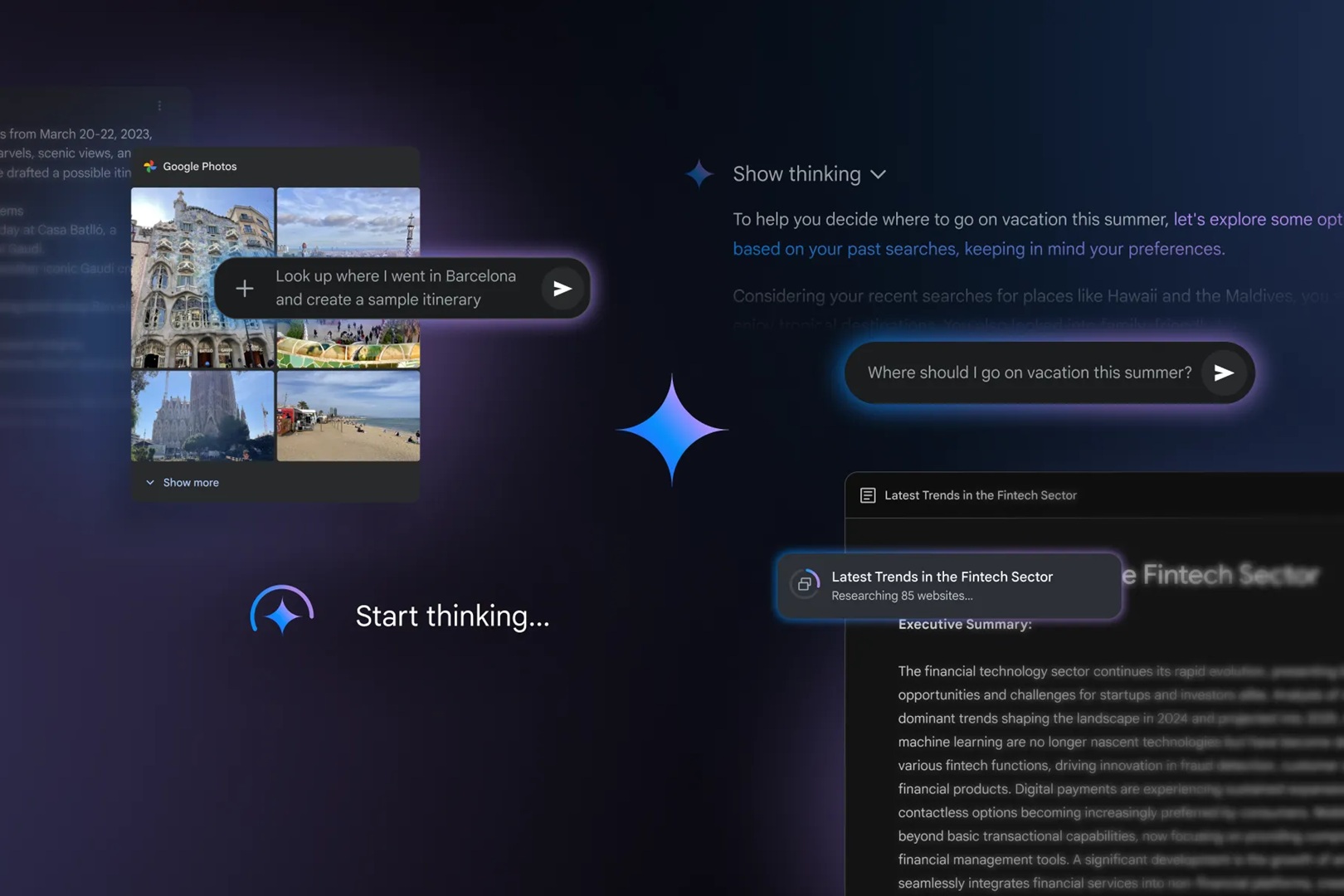

A partire dalla lingua inglese, app come Google Calendar, Note di Keep, Google Tasks e Google Foto stanno diventando disponibili con il modello 2.0 Flash Thinking Experimental.

Nelle prossime settimane, invece, l’app Google Foto sarà aggiunta alle “App” (quelle che prima si chiamavano Estensioni) e potrà essere utilizzata (dagli utenti maggiorenni) per chiedere all’assistente informazioni o suggerimenti basati sulle foto.

Le “Gem” sono ora disponibili per tutti

Durante il Google I/O 2024, Google ha lanciato le Gems, una funzionalità che permette di creare una versione personalizzata dell’assistente per specifici scopi d’uso. Inizialmente disponibile per i soli abbonati Advanced, la funzionalità è ora disponibile anche per gli utenti standard.

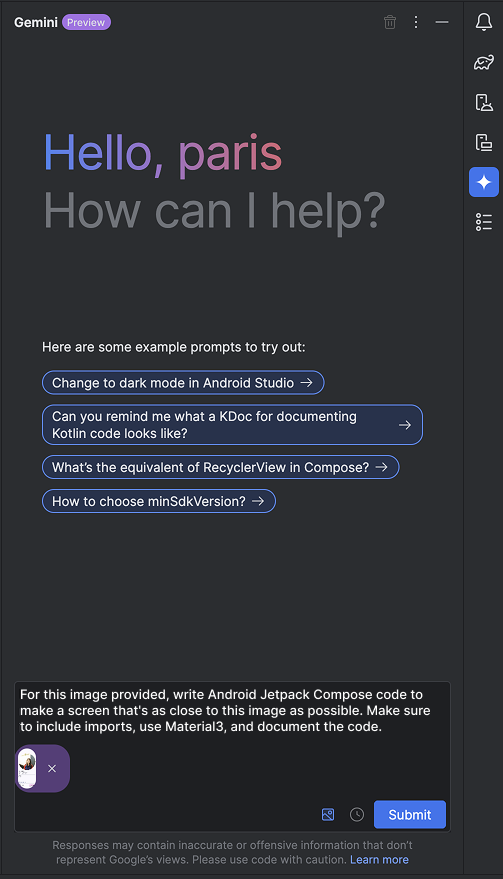

Gemini in Android Studio impara a trasformare i bozzetti di UI in codice

Restando sempre in ambito Gemini, l’ultima novità di giornata si concretizza all’interno di Android Studio e, più nello specifico, tramite la nuova versione Narwhal (canary) della piattaforma.

Google ha infatti arricchito la versione di Gemini integrata in Android Studio con una capacità multi-modale già annunciata al Google I/O 2024:

Ora puoi allegare immagini direttamente ai tuoi prompt di Gemini all’interno di Android Studio. Ottieni informazioni immediate su diagrammi tecnici complessi o utilizza bozze di design per generare scheletri di codice corrispondenti. Questa integrazione fluida del contesto visivo nel tuo flusso di lavoro assistito dall’IA sblocca nuovi livelli di efficienza e creatività.

Con questa novità, l’assistente è in grado di comprendere le immagini, come ad esempio i bozzetti di interfacce grafiche (allegabili come file alla chat), e trasformarli in codice Jetpack Compose funzionante.

Per maggiori dettagli, vi rimandiamo al post dedicato che Google ha pubblicato sul blog degli sviluppatori Android.