Quando utilizziamo l’intelligenza artificiale per informarci, quanto possiamo davvero fidarci di ciò che leggiamo?

La domanda è legittima e, peraltro, la sua risposta sta diventando sempre più urgente, considerando che il 15% dei giovani sotto i 25 anni si affida ormai all’IA per restare aggiornato sulle notizie.

Ebbene, un’ampia ricerca condotta dalla European Broadcasting Union e dalla BBC ha cercato di dare una risposta, analizzando le prestazioni dei principali sistemi di intelligenza artificiale nel fornire riassunti di notizie. I risultati non sono incoraggianti, soprattutto per quanto riguarda Google Gemini.

Motorola edge 60, 8/256 GB

50+50+10MP, 6.67'' pOLED 120Hz, Batteria 5200mAh, ricarica 68W, Android 15

Come è stato condotto lo studio

La ricerca ha coinvolto quattro dei più diffusi assistenti basati su intelligenza artificiale: OpenAI ChatGPT, Google Gemini, Microsoft Copilot e Perplexity.

La BBC ha inizialmente condotto un’indagine su larga scala nel Regno Unito, affiancata da sei gruppi di discussione, per raccogliere dati sulle esperienze e le opinioni degli utenti riguardo a questi sistemi.

Successivamente, l’approccio è stato ampliato dalla EBU per un’analisi a livello internazionale, con l’obiettivo di valutare quanto questi strumenti siano affidabili quando si tratta di sintetizzare e presentare informazioni giornalistiche.

I ricercatori hanno esaminato non solo l’accuratezza delle informazioni fornite, ma anche aspetti come la capacità di identificare fonti attendibili, la corretta citazione di dichiarazioni, la presenza di collegamenti alle fonti originali e la contestualizzazione appropriata delle notizie. Un lavoro che appare dunque piuttosto complesso, e che ha rivelato problematiche diffuse in tutti i sistemi analizzati, con differenze significative tra le varie piattaforme.

Segui Google Italia su Telegram, ricevi news e offerte per primo

Fiducia elevata ma consapevolezza insufficiente

Uno degli aspetti più interessanti emersi dallo studio riguarda il rapporto di fiducia che gli utenti hanno sviluppato con l’intelligenza artificiale.

Nel Regno Unito, per esempio, il 42% degli adulti coinvolti nella ricerca ha dichiarato di fidarsi dell’accuratezza dell’IA, con percentuali ancora più alte tra i giovani. Un dato che acquisisce particolare rilevanza se si considera che l’84% degli intervistati ha affermato che gli errori fattuali comprometterebbero significativamente questa fiducia.

Ebbene, è proprio qui che salta agli occhi un evidente paradosso: da una parte le persone dichiarano di essere molto preoccupate per l’accuratezza e affermano che gli errori minerebbero la loro fiducia, ma dall’altra parte i dati suggeriscono che la maggior parte degli utenti non si accorge effettivamente delle inesattezze presenti nei contenuti generati dall’IA. Si crea così una situazione potenzialmente pericolosa, in cui la fiducia dichiarata non corrisponde a una reale capacità di valutazione critica delle informazioni ricevute.

I problemi sono molto più diffusi di quanto si pensi

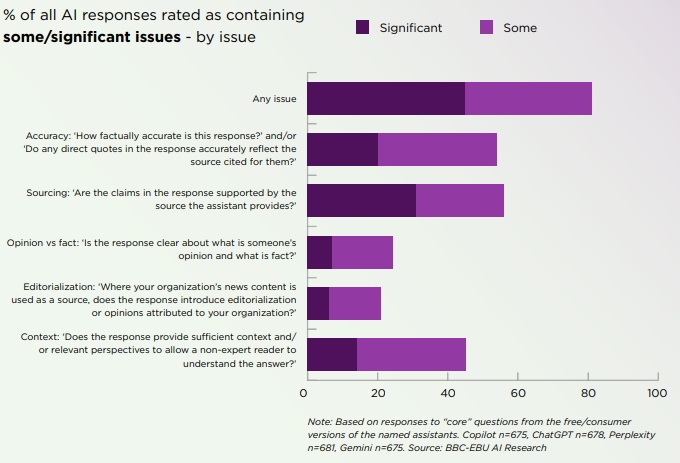

I risultati della ricerca hanno rivelato inoltre che la maggior parte delle risposte fornite dai sistemi di intelligenza artificiale presentava qualche tipo di problema.

Per esempio, nessuno dei modelli valutati ha ottenuto prestazioni eccellenti, e molti si sono collocati sostanzialmente nello stesso range di qualità. Tuttavia, Google Gemini si è distinto negativamente, in maniera peraltro notevole.

Gemini ha infatti mostrato problematiche sia per quanto riguarda il totale complessivo delle imprecisioni, sia soprattutto per la quantità di errori considerati di conseguenza significativa. Proprio questo secondo aspetto sembra essere quello più preoccupante, perché indica che non si tratta solo di piccole sviste o imperfezioni marginali, ma di problemi che possono davvero compromettere la comprensione corretta degli eventi da parte degli utenti.

Quali sono stati i problemi riscontrati in Gemini?

Più nel dettaglio, i ricercatori hanno identificato una serie di problemi specifici che affliggono Google Gemini quando si tratta di elaborare e presentare contenuti giornalistici.

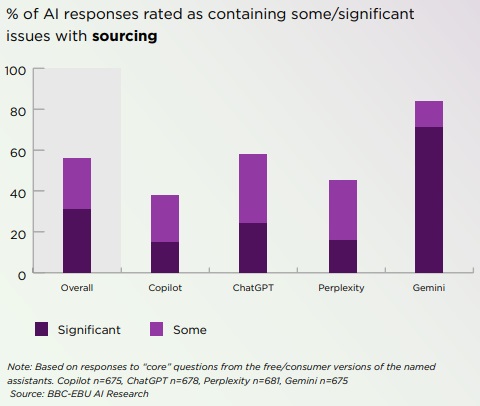

Innanzitutto, è emersa una significativa mancanza di collegamenti chiari alle fonti, rendendo così difficile per gli utenti verificare le informazioni o approfondire le notizie consultando le fonti originali, un aspetto che è invece fondamentale per un consumo consapevole dell’informazione.

Un altro problema grave riguarda l’incapacità di distinguere tra fonti affidabili e contenuti satirici. In un’epoca in cui la satira politica e sociale è sempre più diffusa online, questa confusione può portare a fraintendimenti pericolosi, con gli utenti che potrebbero scambiare notizie false o parodistiche per informazioni autentiche. Gemini mostra inoltre un eccessivo affidamento su Wikipedia come fonte: evidentemente, non è un elemento necessariamente negativo, ma limita comunque la diversità delle prospettive e può portare a una narrazione eccessivamente semplificata di questioni complesse.

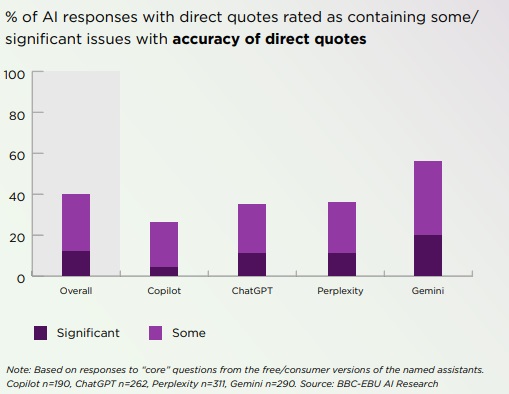

La ricerca ha poi evidenziato anche una diffusa delusione nel fornire il contesto appropriato alle notizie. Le informazioni giornalistiche raramente esistono in un vuoto: comprendere il background storico, politico o sociale di un evento è spesso cruciale per interpretarlo correttamente. Infine, uno degli errori più gravi riguarda il trattamento delle citazioni dirette, che vengono spesso distorte o riportate in modo impreciso, alterando potenzialmente il significato delle dichiarazioni originali.

Miglioramenti progressivi, ma il gap è ancora profondo

Ad ogni modo, non mancano gli aspetti positivi. Dalla ricerca emerge infatti come questi sistemi si stiano evolvendo nel tempo, mostrando che a distanza di sei mesi l’uno dall’altro, tutti i sistemi di intelligenza artificiale analizzati hanno mostrato miglioramenti, presentando meno problemi nei riassunti di notizie rispetto all’inizio dello studio.

Insomma, il dato suggerisce che gli sviluppatori stanno lavorando attivamente per correggere i difetti e migliorare l’accuratezza. Google Gemini, in particolare, ha registrato alcuni dei progressi più significativi in termini di accuratezza. Tuttavia, nonostante questi miglioramenti, il sistema continua a mostrare un numero molto più elevato di problemi nelle sue elaborazioni rispetto ai concorrenti.

Il divario che separava Gemini dagli altri sistemi all’inizio dello studio si è ridotto, ma non è scomparso, e l’assistente di Google rimane il meno affidabile tra quelli analizzati per quanto riguarda la sintesi di contenuti giornalistici.

Di cosa dovrebbero essere consapevoli gli utenti

Lo studio ha avuto il merito di sollevare alcune questioni piuttosto importanti sul modo in cui ci informiamo nell’era dell’intelligenza artificiale. Se una percentuale crescente di persone, specialmente tra i più giovani, si affida a questi sistemi per restare aggiornata sulle notizie, la presenza di errori significativi e la difficoltà nel distinguere fonti attendibili da contenuti non affidabili sono un problema serio per la qualità del dibattito pubblico e per la capacità dei cittadini di prendere decisioni informate.

Nel frattempo, Google non ha ancora fornito commenti ufficiali sui metodi o sui risultati condivisi dalla ricerca.