La prossima rivoluzione in materia di fotocamere potrebbe essere già iniziata e potrebbe consentirci, una volta portata a compimento, di guardare attraverso i muri e persino nel cervello.

Le fotocamere degli smartphone si sono evolute rapidamente negli ultimi anni. Si è passati a stretto giro di posta da accessori quanto mai rudimentali alle attuali tecnologie senza dubbio molto più avanzate. Allo stato attuale le fotocamere degli smartphone permettono di ottenere risultati impensabili fino a pochi anni fa. Adesso gli utenti possono sfruttare feature interessanti come il riconoscimento del proprio volto e girare video in slow motion in ultra-high definition. Tecnologie come queste potrebbero, in realtà, rappresentare il mero punto di partenza di una rivoluzione di ben altra portata e che, peraltro, potrebbe essere già iniziata.

Le ultime ricerche nel campo delle fotocamere stanno spostando l’attenzione dall’aumento del numero dei megapixel verso tutt’altra direzione, ovvero la fusione dei dati catturati dalla fotocamera con l’elaborazione computazionale. Per essere chiari, non si parla di elaborazione in stile Photoshop, dove effetti e filtri vengono aggiunti ad una foto, quanto piuttosto di un approccio radicalmente nuovo in cui i dati in ingresso potrebbero non avere affatto l’aspetto di un’immagine. In sostanza, si arriverebbe all’immagine soltanto dopo una serie di passaggi computazionali, che spesso coinvolgono complessi calcoli matematici e modellano il modo in cui la luce viaggia attraverso la scena o la fotocamera.

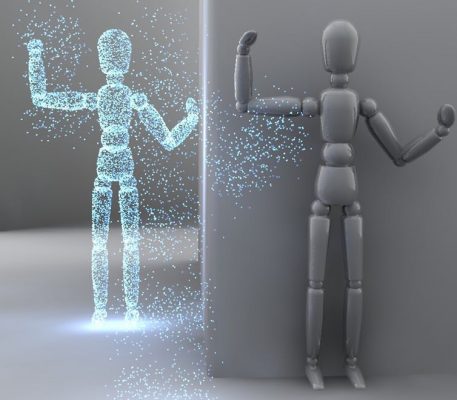

Questo livello ulteriore di elaborazione computazionale ci libera magicamente da tutte le convenzionali tecniche di imaging. Un giorno potremmo persino non aver più bisogno di una fotocamera intesa in senso convenzionale. Piuttosto utilizzeremo dei rilevatori di luce, che solo pochi anni fa non avremmo mai nemmeno preso in considerazione per un utilizzo in campo imaging. Questi strumenti saranno in grado di fare cosa che sembrano ora incredibili, come vedere attraverso la nebbia, all’interno del corpo umano e persino attraverso i muri.

Fotocamere a singolo pixel

Un esempio estremo sono le fotocamere a singolo pixel, che si basano su un principio magnificamente semplice. Le fotocamere tipiche usano molti pixel per catturare una scena che è verosimilmente illuminata da una singola fonte di luce. Ebbene queste fotocamere lavorano in modo esattamente opposto, catturando le informazioni provenienti da molteplici fonti di luce con un solo pixel.

Per fare questo si ha bisogno di una fonte di luce controllata, per esempio un semplice proiettore di dati che illumina la scena un punto alla volta o con una serie di pattern differenti. Per ciascun punto o pattern di illuminazione, si misura la quantità di luce riflessa e si uniscono tutte le informazioni per creare l’immagine finale. Chiaramente lo svantaggio di scattare foto in questo modo è che bisogna usare molteplici punti o pattern di illuminazione per produrre una singola immagine. Tuttavia questa forma di imaging permetterebbe di creare fotocamere altrimenti impossibili, ad esempio funzionanti a lunghezze d’onda di luce oltre lo spettro visibile, ipotesi in cui quindi i rilevatori non potrebbero essere utilizzati come fotocamere.

Queste fotocamere potrebbero essere usate per scattare foto attraverso la nebbia o la neve che cade fitta. Oppure, imitando gli occhi di alcuni animali, potrebbero aumentare automaticamente la risoluzione di un’immagine (la quantità di dettagli catturati) a seconda della scena. Sarebbe persino possibile catturare immagini da particelle di luce che non hanno mai nemmeno interagito con l’oggetto che s’intende fotografare. Ciò trarrebbe vantaggio dall’idea di “entanglement quantico“, ovvero che due particelle possono essere collegate in modo che qualsiasi cosa accada all’una, accade anche all’altra, anche qualora si trovino a grande distanza. Tutto questo porta con sé possibilità intriganti, come guardare un oggetto le cui proprietà potrebbero essere diverse quando illuminato. Si pensi, ad esempio, all’occhio: una retina ha lo stesso aspetto al buio ed illuminata?

Multi-sensor imaging

L’imaging a singolo pixel è solo una delle più semplici innovazioni in arrivo nella tecnologia delle fotocamere e fa affidamento, a prima vista, sul tradizionale concetto di ciò che costituisce un’immagine. Ma al momento stiamo assistendo alla crescita dell’interesse verso sistemi che usano tantissime informazioni, di cui le tecniche tradizionali sono in grado di raccogliere solo una piccola parte.

In questo senso potrebbe entrare in gioco l’approccio multi-sensor, che prevede molti rilevatori puntati sulla stessa scena. Il telescopio di Hubble ne è stato un esempio pionieristico, producendo immagini realizzate attraverso combinazioni di molteplici altre immagini catturate a lunghezze d’onda diverse. Ma ora è possibile acquistare versioni commerciali di questo tipo di tecnologia, come la Lytro camera, che raccoglie informazioni sull’intensità e la direzione della luce sullo stesso sensore, per produrre immagini in cui è possibile il re-focus dopo che l’immagine stessa è stata catturata.

Il prossimo approccio

La prossima generazione di fotocamere potrebbe assomigliare alla Light L16 camera (che potete vedere nell’immagine d’apertura) che presenta una tecnologia innovativa, basata sulla presenza di dieci sensori diversi. Tutti i loro dati sono elaborati da un computer per creare immagini di qualità professionale, da 50 MB, re-focusable e re-zoomable. La Light L16 è un oggetto molto particolare e lo dimostra anche il suo aspetto piuttosto singolare.

Eppure questi sono soltanto i primi passi verso la prossima generazione di fotocamere, che cambierà radicalmente il nostro modo di pensare e di catturare immagini. Come detto, i ricercatori sono al lavoro per risolvere il problema di vedere attraverso la nebbia, dietro le pareti e persino nelle profondità del corpo e del cervello umano.

Tutte le tecniche si basano su combinazioni di immagini secondo modelli che spiegano in che modo la luce viaggi attraverso o attorno a differenti sostanze.

Un altro approccio interessante che sta guadagnando seguito si basa sull’apprendimento da parte dell’intelligenza artificiale a riconoscere oggetti dai dati. Queste tecniche si ispirano a processi di apprendimento propri del cervello umano e potrebbero svolgere un ruolo centrale nei futuri sistemi di imaging.

“Single photon” e “quantum imaging technologies” stanno inoltre maturando al punto tale che sono in grado di catturare immagini con livelli di luce incredibilmente bassi e girare video con velocità elevatissime, raggiungendo addirittura un trilione di frame al secondo. Sarebbe sufficiente per catturare persino immagini della luce stessa che viaggia attraverso una scena.

Alcune di queste idee potrebbero richiedere un bel po’ di tempo prima di essere pienamente sviluppate, tuttavia la fisica potrebbe consentire la risoluzione di questi ed altri problemi, attraverso una combinazione di nuove tecnologie ed ingegnosità computazionale.