L‘intelligenza artificiale di Google sta per cambiare ancora e, probabilmente, lo farà in una direzione che potrebbe migliorare l’analisi dei contenuti visivi dei propri utenti.

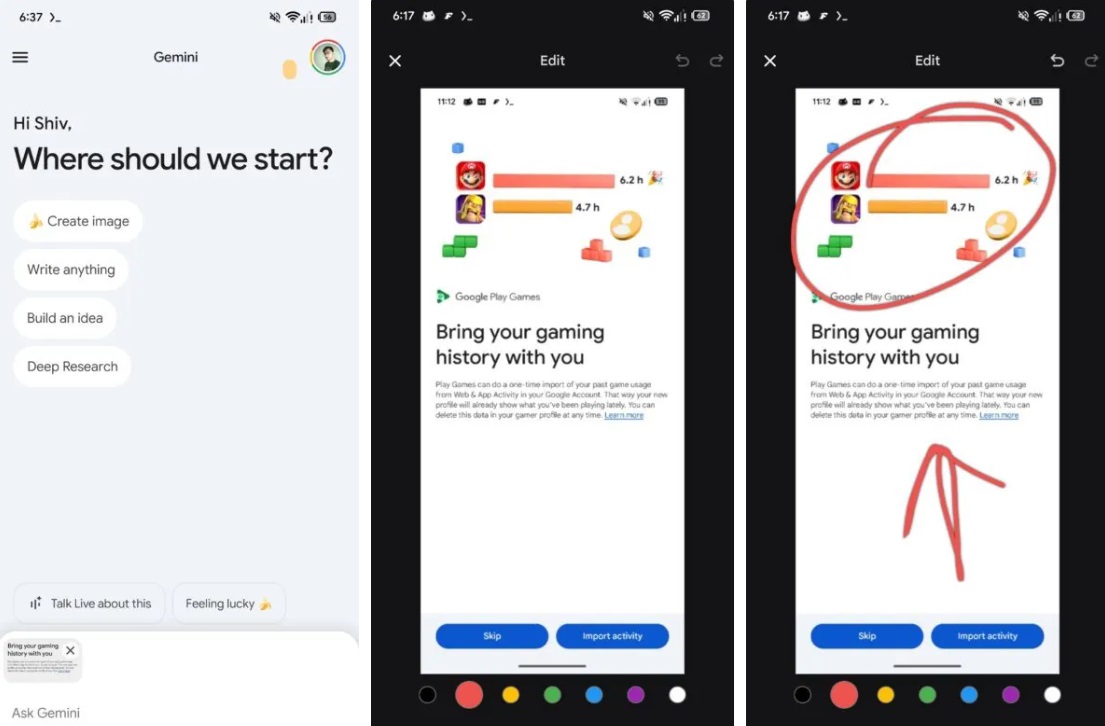

Con la versione 16.42.61 dell’app sembra infatti emergere la possibilità di evidenziare e disegnare direttamente sulle immagini prima di sottoporle all’analisi di Gemini. L’approccio non è ovviamente originalissimo (prende per esempio ispirazione da Circle to Search di Samsung), ma lo porta ad un altro livello più sofisticato di integrazione con l’intelligenza artificiale di Google.

Attualmente, infatti, quando un utente carica un’immagine su Gemini, l’AI analizza l’intero contenuto visivo senza distinzioni particolari. La nuova modalità di funzionamento, per quanto efficace in molti scenari, presenta dei limiti evidenti quando si desidera concentrare l’attenzione dell’intelligenza artificiale su un dettaglio specifico o su una porzione limitata dell’immagine.

Ebbene, la soluzione che Google sta sviluppando risponde proprio a questa esigenza, offrendo agli utenti il controllo diretto su ciò che l’AI dovrebbe esaminare con maggiore attenzione.

Motorola edge 60, 8/256 GB

50+50+10MP, 6.67'' pOLED 120Hz, Batteria 5200mAh, ricarica 68W, Android 15

Come funzioneranno gli strumenti di markup?

Il nuovo sistema di markup si inserisce così nel flusso di lavoro esistente in modo naturale. Dopo aver selezionato un’immagine dalla galleria o scattato una nuova foto con la fotocamera, l’utente avrà accesso a una serie di strumenti di disegno che permetteranno di evidenziare, cerchiare o altrimenti marcare le porzioni dell’immagine rilevanti.

L’interfaccia, pur apparendo ancora in fase di sviluppo, include già la possibilità di scegliere tra diversi colori, sebbene non sia ancora chiaro quale sarà il ruolo specifico di questa funzionalità nella versione finale.

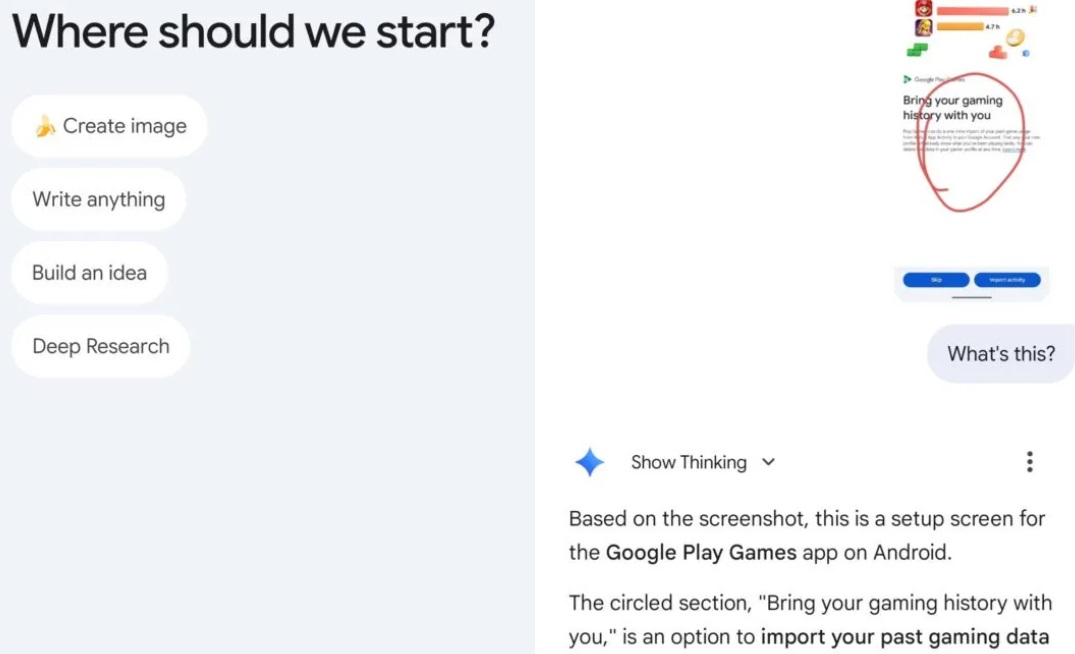

L’intelligenza di Gemini dimostra già una notevole capacità di comprensione contestuale. Anche senza istruzioni esplicite, l’AI è in grado di riconoscere che una porzione cerchiata o evidenziata rappresenta un elemento su cui l’utente desidera concentrare l’attenzione. Naturalmente, resta sempre possibile fornire indicazioni dirette e specifiche su cosa fare con la regione evidenziata, garantendo un controllo ancora maggiore sul risultato dell’analisi.

Segui Google Italia su Telegram, ricevi news e offerte per primo

L’integrazione con Nano Banana e le capacità di editing

Una delle applicazioni più interessanti di questa nuova funzionalità riguarda l’integrazione con Nano Banana, il sistema di editing delle immagini basato su AI. Attraverso il nuovo flusso di input con markup, gli utenti potranno rapidamente rimuovere contenuti indesiderati dagli screenshot o dalle foto, semplicemente evidenziando la porzione da eliminare e fornendo un comando appropriato a Gemini.

È evidentemente un bel passo in avanti in termini di facilità d’uso e di velocità di esecuzione: invece di dover utilizzare strumenti di editing complessi o passare attraverso multiple applicazioni, l’utente potrà gestire operazioni di modifica delle immagini direttamente dall’interfaccia di Gemini, sfruttando la potenza dell’intelligenza artificiale per ottenere risultati professionali con il minimo sforzo.

Cosa cambierà nel concreto con questa novità

Sebbene l’interfaccia attuale appaia ancora generica e probabilmente destinata a subire modifiche prima del lancio pubblico, il potenziale di questa aggiunta al toolkit di Gemini sembra essere davvero notevole.

Google potrebbe infatti scegliere di perfezionare ulteriormente il modo in cui gli utenti accedono a questi strumenti e marcano le immagini, anche se la direzione intrapresa appare chiara e promettente.

La possibilità di condurre l’attenzione dell’intelligenza artificiale su specifiche porzioni di un’immagine apre infatti scenari d’uso molto diversificati. Potranno per esempio farne tesoro professionisti che necessitano di analisi dettagliate di particolari tecnici, studenti che vogliono approfondire elementi specifici in materiali didattici, utenti comuni che desiderano semplicemente ottenere informazioni più precise su oggetti o dettagli presenti nelle loro foto. Tutti, insomma, potrebbero beneficiare di questa funzionalità.

L’evoluzione di Gemini è in altri termini un esempio di come l’intelligenza artificiale stia progressivamente diventando più intuitiva e adattabile alle esigenze umane. In questo caso, la possibilità di indicare ciò di cui si vuole parlare all’intelligenza artificiale rispecchia infatti la comunicazione umana naturale, dove gestiamo frequentemente il focus dell’attenzione attraverso segnali visivi e indicazioni dirette. Portare questo approccio comunicativo nell’interazione quotidiana con l’AI è dunque un passo significativo verso sistemi più comprensibili e accessibili a tutti. Attendiamo ora solo la presentazione ufficiale di questa innovazione.